Como instalar o Hadoop no Ubuntu 18.04 Bionic Beaver Linux

- 4199

- 1206

- Mr. Mitchell Hansen

Apache Hadoop é uma estrutura de código aberto usado para armazenamento distribuído, bem como processamento distribuído de big data em grupos de computadores que são executados em commodity hardwares. O Hadoop armazena dados no Hadoop Distributed File System (HDFS) e o processamento desses dados é feito usando o MapReduce. O YARN fornece API para solicitar e alocar recursos no cluster Hadoop.

A estrutura do Apache Hadoop é composta pelos seguintes módulos:

- Hadoop comum

- Sistema de arquivos distribuído Hadoop (HDFS)

- FIO

- MapReduce

Este artigo explica como instalar o Hadoop versão 2 no Ubuntu 18.04. Instalaremos o HDFS (Namenode e DataNode), Yarn, MapReduce no cluster de um nó único no modo pseudo distribuído, que é distribuído simulação em uma única máquina. Cada daemon Hadoop, como HDFs, fios, MapReduce etc. será executado como um processo Java separado/individual.

Neste tutorial, você aprenderá:

- Como adicionar usuários para o ambiente Hadoop

- Como instalar e configurar o Oracle JDK

- Como configurar ssh sem senha

- Como instalar o Hadoop e configurar os arquivos XML relacionados necessários

- Como começar o cluster Hadoop

- Como acessar o Namenode e o ResourceManager Web UI

Interface do usuário da Web Namenode.

Interface do usuário da Web Namenode. Requisitos de software e convenções usadas

| Categoria | Requisitos, convenções ou versão de software usada |

|---|---|

| Sistema | Ubuntu 18.04 |

| Programas | Hadoop 2.8.5, Oracle JDK 1.8 |

| Outro | Acesso privilegiado ao seu sistema Linux como raiz ou através do sudo comando. |

| Convenções | # - requer que os comandos Linux sejam executados com privilégios root diretamente como usuário root ou por uso de sudo comando$ - Requer que os comandos do Linux sejam executados como um usuário não privilegiado regular |

Outras versões deste tutorial

Ubuntu 20.04 (fossa focal)

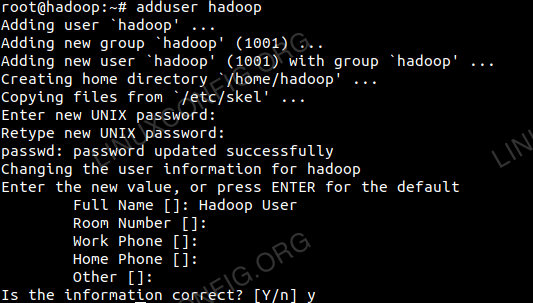

Adicione usuários para o Hadoop Environment

Crie o novo usuário e grupo usando o comando:

# adicionar usuário

Adicione novo usuário para Hadoop.

Adicione novo usuário para Hadoop.

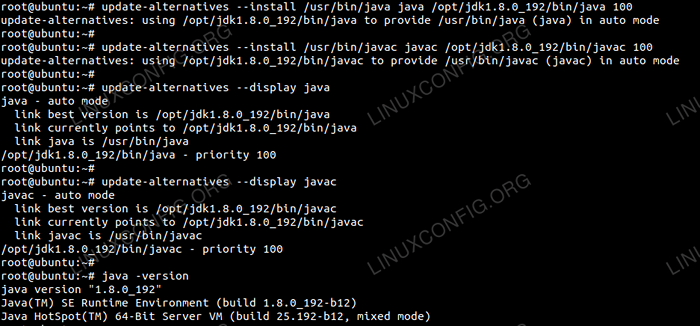

Instale e configure o Oracle JDK

Baixar e extrair o arquivo java sob o /optar diretório.

# cd /opt # tar -xzvf jdk-8u192-linux-x64.alcatrão.gz

ou

$ tar -xzvf jdk-8u192-linux-x64.alcatrão.gz -c /opt

Para definir o JDK 1.8 Atualização 192 Como JVM padrão, usaremos os seguintes comandos:

# Update-Alternatives--Install/usr/bin/java java/opt/jdk1.8.0_192/bin/java 100 # atualização-alternativas--install/usr/bin/javac javac/opt/jdk1.8.0_192/bin/javac 100

Após a instalação para verificar se o Java foi configurado com sucesso, execute os seguintes comandos:

# Update-Alternatives-Display Java # Update-Alternatives-Display Javac

Oraclejdk Instalação e configuração.

Oraclejdk Instalação e configuração. Configure ssh sem senha

Instale o servidor SSH aberto e abra o cliente SSH com o comando:

# sudo apt-get install OpenSsh-Server OpenSsh-Client

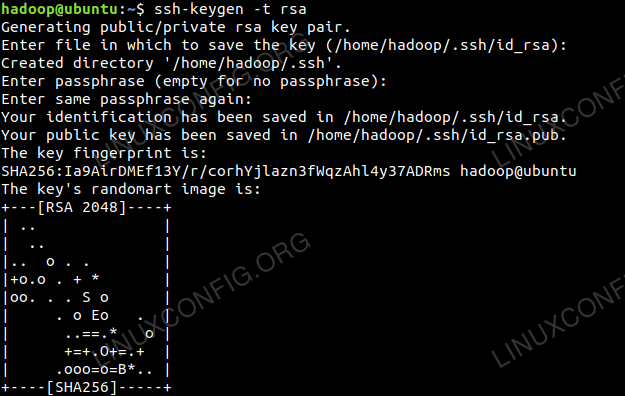

Gerar pares de chave pública e privada com o seguinte comando. O terminal solicitará a entrada do nome do arquivo. Imprensa DIGITAR e prossiga. Depois disso, copie o formulário das chaves públicas id_rsa.bar para Autorizado_keys.

$ ssh -keygen -t rsa $ cat ~/.ssh/id_rsa.pub >> ~///.ssh/autorizado_keys

Configuração SSH sem senha.

Configuração SSH sem senha.

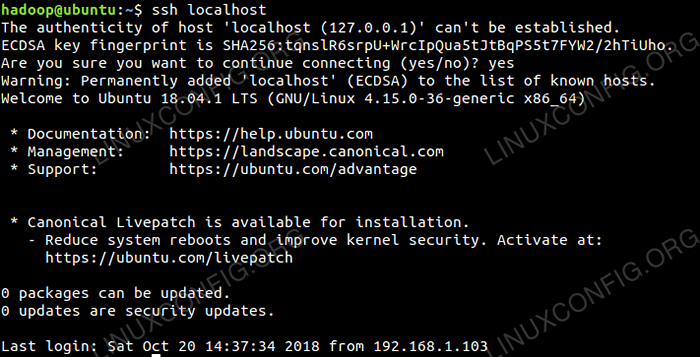

Verifique a configuração SSH sem senha com o comando:

$ ssh host

Verificação sshless ssh.

Verificação sshless ssh.

Instale o Hadoop e configure arquivos XML relacionados

Baixar e extrair o Hadoop 2.8.5 Do site oficial do Apache.

# tar -xzvf hadoop -2.8.5.alcatrão.gz

Configurando as variáveis de ambiente

Editar o Bashrc Para o usuário do Hadoop através da configuração das seguintes variáveis de ambiente Hadoop:

exportar hadoop_home =/home/hadoop/hadoop-2.8.5 exportar hadoop_install = $ hadoop_home export hadoop_mapred_home = $ hadoop_home export hadoop_common_home = $ hadoop_home export hadoop_hdfs_home = $ hadoop_home exportar yarn_home = $ hadoop_home hadaop_common_lib_native_nativo exportar Hadoop_Opts = "-Djava.biblioteca.caminho = $ hadoop_home/lib/nativo " Fonte do .Bashrc Na sessão de login atual.

$ fonte ~//.Bashrc

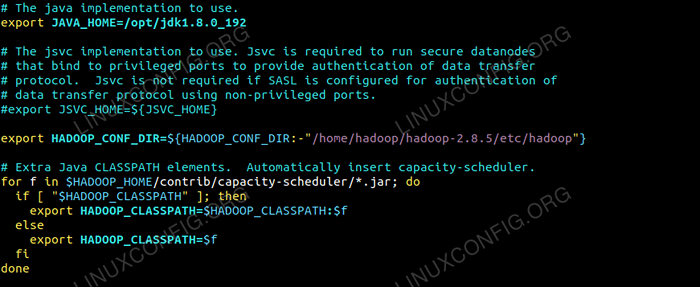

Editar o Hadoop-env.sh arquivo que está em /etc/hadoop Dentro do diretório de instalação do Hadoop, faça as seguintes alterações e verifique se você deseja alterar outras configurações.

exportar java_home =/opt/jdk1.8.0_192 Exportar hadoop_conf_dir = $ hadoop_conf_dir:-"/home/hadoop/hadoop-2.8.5/etc/hadoop "  Mudanças no Hadoop-ENV.Arquivo SH.

Mudanças no Hadoop-ENV.Arquivo SH. Alterações de configuração no local do núcleo.Arquivo XML

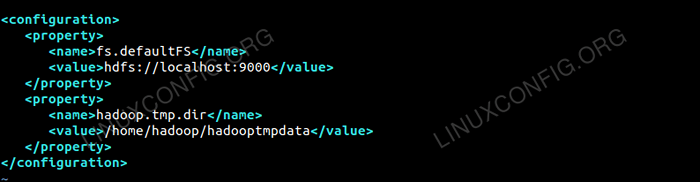

Editar o Site do núcleo.xml com vim ou você pode usar qualquer um dos editores. O arquivo está sob /etc/hadoop dentro Hadoop diretório doméstico e adicione as seguintes entradas.

fs.Defaultfs hdfs: // localhost: 9000 Hadoop.TMP.dir /home/hadoop/hadooptmpdata Além disso, crie o diretório em Hadoop Pasta em casa.

$ mkdir hadooptmpdata

Configuração para o local do núcleo.Arquivo XML.

Configuração para o local do núcleo.Arquivo XML. Alterações de configuração no site HDFS.Arquivo XML

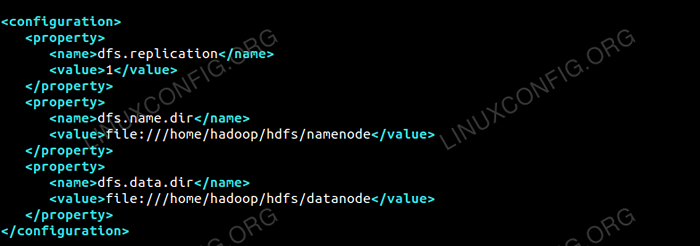

Editar o Site HDFS.xml que está presente no mesmo local I.e /etc/hadoop dentro Hadoop diretório de instalação e criar o Namenode/datanode diretórios abaixo Hadoop diretório inicial do usuário.

$ mkdir -p hdfs/namenode $ mkdir -p hdfs/datanode

dfs.replicação 1 dfs.nome.dir Arquivo: /// home/hadoop/hdfs/namenode dfs.dados.dir Arquivo: /// home/hadoop/hdfs/dataNode  Configuração para o site HDFS.Arquivo XML.

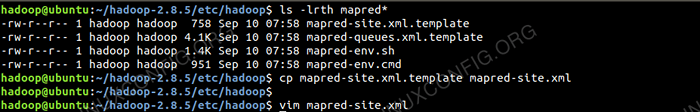

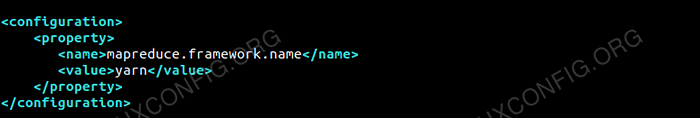

Configuração para o site HDFS.Arquivo XML. Alterações de configuração no MapRed-Site.Arquivo XML

Copie o MapRed-site.xml de MapRed-site.xml.modelo usando cp comando e depois edite o MapRed-site.xml colocado em /etc/hadoop sob Hadoop Diretório de instilação com as seguintes mudanças.

$ CP MapRed-Site.xml.Modelo MAPRED-SITE.xml

Criando o novo MAPRED-SITE.Arquivo XML.

Criando o novo MAPRED-SITE.Arquivo XML. MapReduce.estrutura.nome fio  Configuração para o MAPRED-SITE.Arquivo XML.

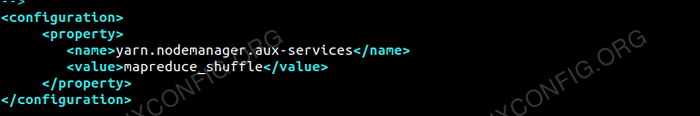

Configuração para o MAPRED-SITE.Arquivo XML. Alterações de configuração no local do fio.Arquivo XML

Editar Site de fio.xml com as seguintes entradas.

MapReduceyarn.NodeManager.Aux-Services mapReduce_shuffle  Configuração para o local do fio.Arquivo XML.

Configuração para o local do fio.Arquivo XML. Iniciando o cluster Hadoop

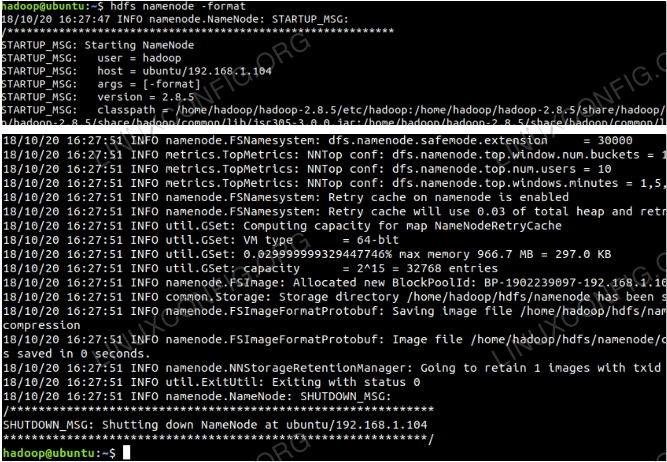

Formate o Namenode antes de usá -lo pela primeira vez. Como o usuário do HDFS executa o comando abaixo para formatar o Namenode.

$ hdfs namenode -format

Formate o namenode.

Formate o namenode.

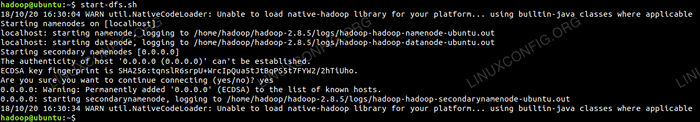

Depois que o namenode for formatado, inicie os HDFs usando o start-dfs.sh roteiro.

Iniciando o script de inicialização do DFS para iniciar o HDFS.

Iniciando o script de inicialização do DFS para iniciar o HDFS.

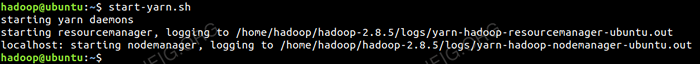

Para iniciar os serviços de fio, você precisa executar o script de início do fio i.e. Start-yarn.sh

Iniciando o script de inicialização de fios para iniciar o fio.

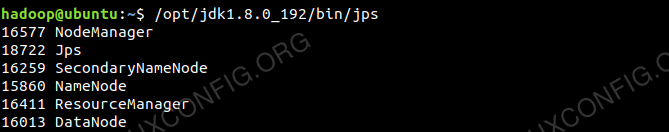

Iniciando o script de inicialização de fios para iniciar o fio. Para verificar todos os serviços/daemons do Hadoop são iniciados com sucesso, você pode usar o JPS comando.

/opt/jdk1.8.0_192/bin/jps 20035 secundário  Saída do Hadoop Daemons do comando jps.

Saída do Hadoop Daemons do comando jps.

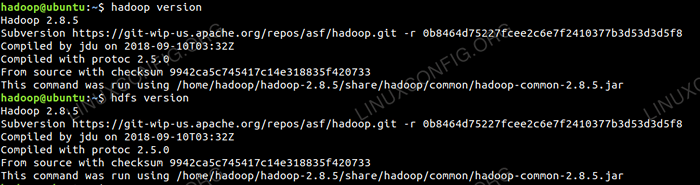

Agora podemos verificar a versão atual do Hadoop que você pode usar abaixo do comando:

$ hadoop versão

ou

Versão $ hdfs

Verifique a versão Hadoop.

Verifique a versão Hadoop.

Interface da linha de comando HDFS

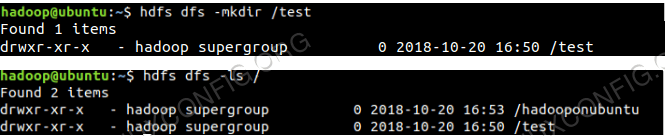

Para acessar o HDFS e criar alguns diretórios em cima do DFS, você pode usar o HDFS CLI.

$ hdfs dfs -mkdir /teste $ hdfs dfs -mkdir /hadoopoNubuntu $ hdfs dfs -ls /

Criação do diretório HDFS usando HDFS CLI.

Criação do diretório HDFS usando HDFS CLI.

Acesse o namenode e o fio do navegador

Você pode acessar a interface do usuário da web para o Namenode e o Yarn Resource Manager por meio de qualquer um dos navegadores como Google Chrome/Mozilla Firefox.

Namenode Web UI - http: //: 50070

Interface do usuário da Web Namenode.

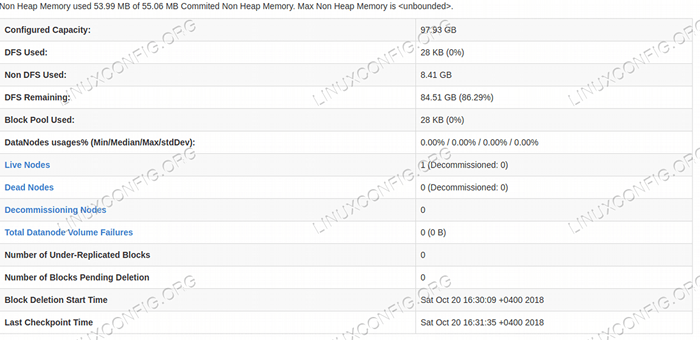

Interface do usuário da Web Namenode.  Detalhes do HDFS da interface do usuário da Web Namenode.

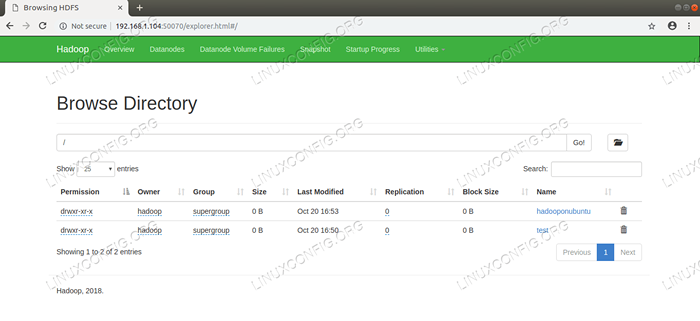

Detalhes do HDFS da interface do usuário da Web Namenode.  Navegação do diretório HDFS via Interface do usuário da Web Namenode.

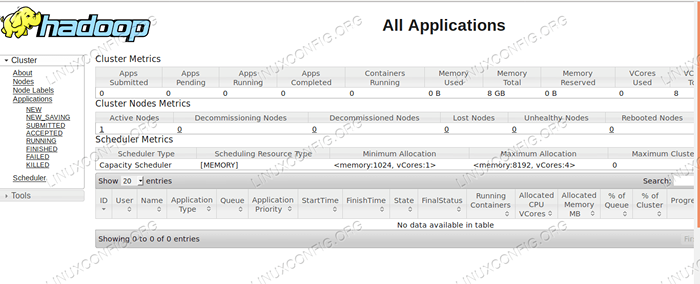

Navegação do diretório HDFS via Interface do usuário da Web Namenode. A interface da web do Yarn Resource Manager (RM) exibirá todos os trabalhos em execução no cluster Hadoop atual.

UI da web do gerenciador de recursos - http: //: 8088

Interface do usuário da web do gerenciador de recursos.

Interface do usuário da web do gerenciador de recursos. Conclusão

O mundo está mudando a maneira como está operando atualmente e os dados grandes estão desempenhando um papel importante nesta fase. Hadoop é uma estrutura que facilita nossa vida enquanto trabalha em grandes conjuntos de dados. Existem melhorias em todas as frentes. O futuro é emocionante.

Tutoriais do Linux relacionados:

- Ubuntu 20.04 Hadoop

- Coisas para instalar no Ubuntu 20.04

- Como criar um cluster Kubernetes

- Como instalar Kubernetes no Ubuntu 20.04 fossa focal linux

- Coisas para fazer depois de instalar o Ubuntu 20.04 fossa focal linux

- Como instalar Kubernetes no Ubuntu 22.04 Jellyfish…

- Coisas para instalar no Ubuntu 22.04

- Como trabalhar com a API de Rest WooCommerce com Python

- Como gerenciar clusters de Kubernetes com Kubectl

- Uma introdução à automação, ferramentas e técnicas do Linux

- « Como instalar o Android Studio em Manjaro 18 Linux

- Como instalar o Google Chrome no Manjaro 18 Linux »