Como instalar o Apache Kafka no Ubuntu 18.04

- 2206

- 325

- Howard Fritsch

Apache Kafka é uma plataforma de streaming distribuída. É útil para a criação de pipelines de dados de streaming em tempo real para obter dados entre os sistemas ou aplicativos. Outro recurso útil são os aplicativos de streaming em tempo real que podem transformar fluxos de dados ou reagir a um fluxo de dados.

Este tutorial ajudará você a instalar o Apache Kafka no Ubuntu 18.04 e Ubuntu 16.04 Sistemas Linux.

Etapa 1 - Instale Java

Apache Kafka exigiu que o Java fosse executado. Você deve ter Java instalado em seu sistema. Execute o comando abaixo para instalar o OpenJDK padrão no seu sistema a partir dos PPAs oficiais. Você também pode instalar a versão específica de aqui.

Atualização do sudo aptsudo apt install default-jdk

Etapa 2 - Baixe o Apache Kafka

Baixe os arquivos binários do Apache Kafka em seu site oficial de download. Você também pode selecionar qualquer espelho próximo para baixar.

wget https: // dlcdn.apache.org/kafka/3.2.0/kafka_2.13-3.2.0.TGZ Em seguida, extraia o arquivo de arquivo

Tar xzf kafka_2.13-3.2.0.TGZsudo mv kafka_2.13-3.2.0/usr/local/kafka

Etapa 3 - Configure arquivos da unidade Kafka Systemd

Em seguida, crie arquivos da unidade Systemd para o serviço Zookeeper e Kafka. Isso ajudará a gerenciar serviços Kafka para iniciar/parar de usar o comando SystemCTL.

Primeiro, crie o arquivo da unidade Systemd para o Zookeeper com o comando abaixo:

sudo vim/etc/systemd/system/zookeeper.serviço Adicione o conteúdo abaixo:

[Unidade] Descrição = Apache Zookeeper Server Documentation = http: // zookeeper.apache.org requer = rede.alvo remoto-fs.Target After = Network.alvo remoto-fs.Target [Service] Type = simples execStart =/usr/local/kafka/bin/zookeeper-server-start.sh/usr/local/kafka/config/zookeeper.Propriedades Execstop =/usr/local/kafka/bin/zookeeper-server-stop.reinicialização sh = on-abnormal [install] wantedby = multi-user.alvo

Salve o arquivo e feche-o.

Em seguida, para criar um arquivo da unidade Kafka Systemd usando o seguinte comando:

sudo vim/etc/systemd/system/kafka.serviço Adicione o conteúdo abaixo. Certifique -se de definir o correto Java_home Caminho conforme o Java instalado em seu sistema.

[Unidade] Descrição = documentação do servidor Apache Kafka = http: // kafka.apache.org/documentação.html requer = zookeeper.Serviço [Serviço] Tipo = Ambiente simples = "Java_home =/usr/lib/jvm/java-1.11.0-openjdk-amd64 "ExecStart =/usr/local/kafka/bin/kafka-server-start.sh/usr/local/kafka/config/servidor.Propriedades exectop =/usr/local/kafka/bin/kafka-server-stop.sh [install] wantedby = multiususer.alvo

Salve o arquivo e feche.

Recarregue o daemon Systemd para aplicar novas alterações.

SystemCTL Daemon-Reload Etapa 4 - Iniciar o servidor Kafka

Kafka exigiu o Zookeeper, então primeiro, inicie um servidor Zookeeper em seu sistema. Você pode usar o script disponível com Kafka para iniciar uma instância do Zoookeeper de um único nó.

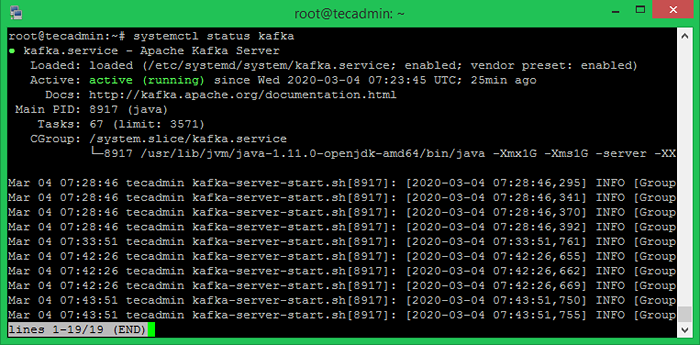

SUDO SYSTEMCTL START Zookeeper Agora inicie o servidor Kafka e visualize o status de execução:

sudo systemctl start kafkaSUDO SYSTEMCTL STATUS KAFKA

Tudo feito. A instalação de Kafka foi concluída com sucesso. Esta parte deste tutorial ajudará você a trabalhar com o servidor Kafka.

Etapa 5 - Crie um tópico em Kafka

Kafka fornece múltiplos scripts de shell pré-construído para trabalhar nele. Primeiro, crie um tópico chamado "TestTopic" com uma única partição com uma única réplica:

CD/usr/local/kafkabin/kafka-topics.sh --create --bootstrap-server localhost: 9092-Replicação-fator 1-Partições 1-TOPIC TESTTICOTeste de tópico criado.

O fator de replicação descreve quantas cópias de dados serão criadas. Como estamos executando com uma única instância, mantenha este valor 1.

Defina as opções de partição como o número de corretores que você deseja que seus dados sejam divididos entre. Como estamos correndo com um único corretor, mantenha este valor 1.

Você pode criar vários tópicos executando o mesmo comando que acima. Depois disso, você pode ver os tópicos criados em Kafka pelo comando Running Abaixo:

bin/kafka-topics.SH -List -Zookeeper localhost: 9092 TestTopic tecadmintutorial1 tecadmintutorial2 Como alternativa, em vez de criar tópicos manualmente, você também pode configurar seus corretores para criar tópicos de criação automática quando um tópico inexistente é publicado para.

Etapa 6 - Envie mensagens para Kafka

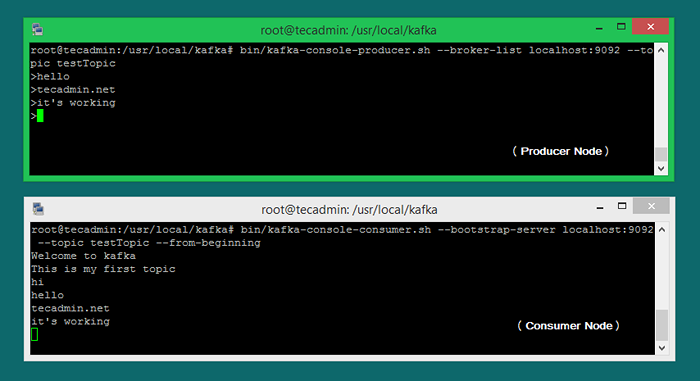

O "produtor" é o processo responsável por colocar dados em nosso kafka. O Kafka vem com um cliente da linha de comando que receberá informações de um arquivo ou de entrada padrão e o enviará como mensagens para o cluster kafka. O Kafka padrão envia cada linha como uma mensagem separada.

Vamos executar o produtor e depois digitar algumas mensagens no console para enviar para o servidor.

Bin/Kafka-Console-produtor.SH-LocalHost de Lista de Bobrista: 9092-Topic Testtopic > Bem -vindo a Kafka> Este é o meu primeiro tópico> Você pode sair deste comando ou manter este terminal em execução para mais testes. Agora abra um novo terminal para o processo de consumidor Kafka na próxima etapa.

Etapa 7 - Usando o consumidor Kafka

Kafka também tem um consumidor de linha de comando para ler dados do cluster kafka e exibir mensagens para saída padrão.

Consumidor-consumidor de Bin/Kafka.SH-LocalHost de servidor sh-Bootstrap: 9092-TOPIC TESTTOPIC-Froginning Bem -vindo a Kafka, este é o meu primeiro tópico Agora, se você ainda está executando o produtor Kafka (Etapa 6) em outro terminal. Basta digitar algum texto nesse terminal do produtor. Irá visível imediatamente no terminal do consumidor. Veja a captura de tela abaixo do produtor e consumidor da Kafka no trabalho:

Conclusão

Você instalou e configurou com sucesso o serviço Kafka em sua máquina Ubuntu Linux.

- « Como desativar a saída Crontab e e -mails no Linux

- Como instalar o S3CMD no Linux e gerenciar baldes S3 »